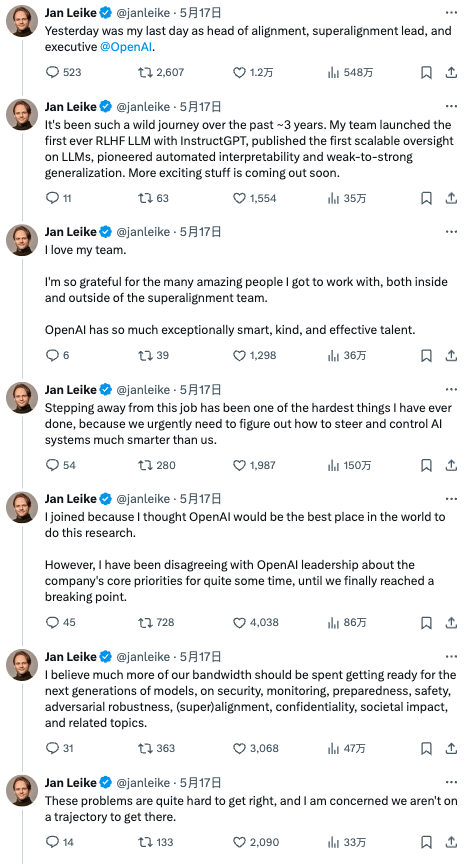

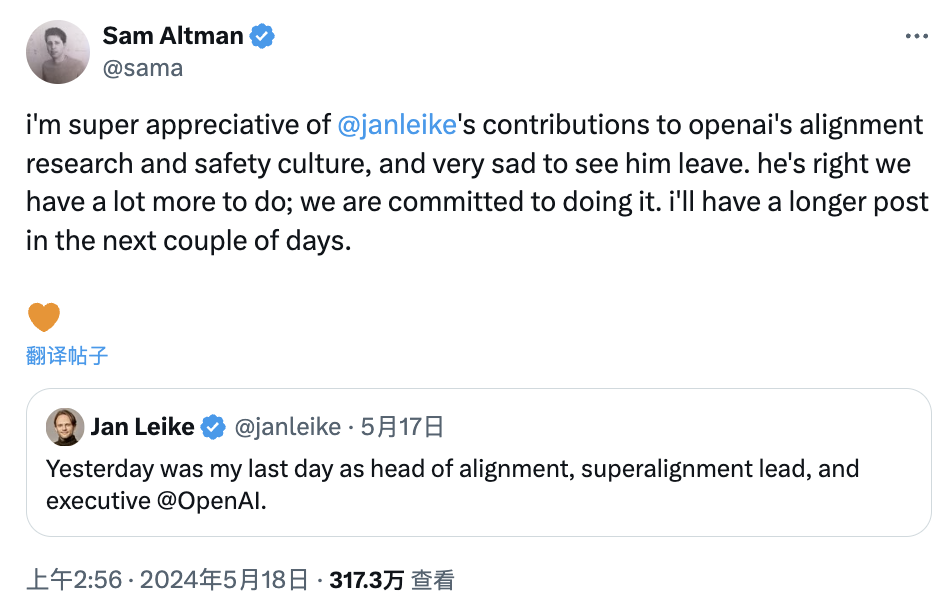

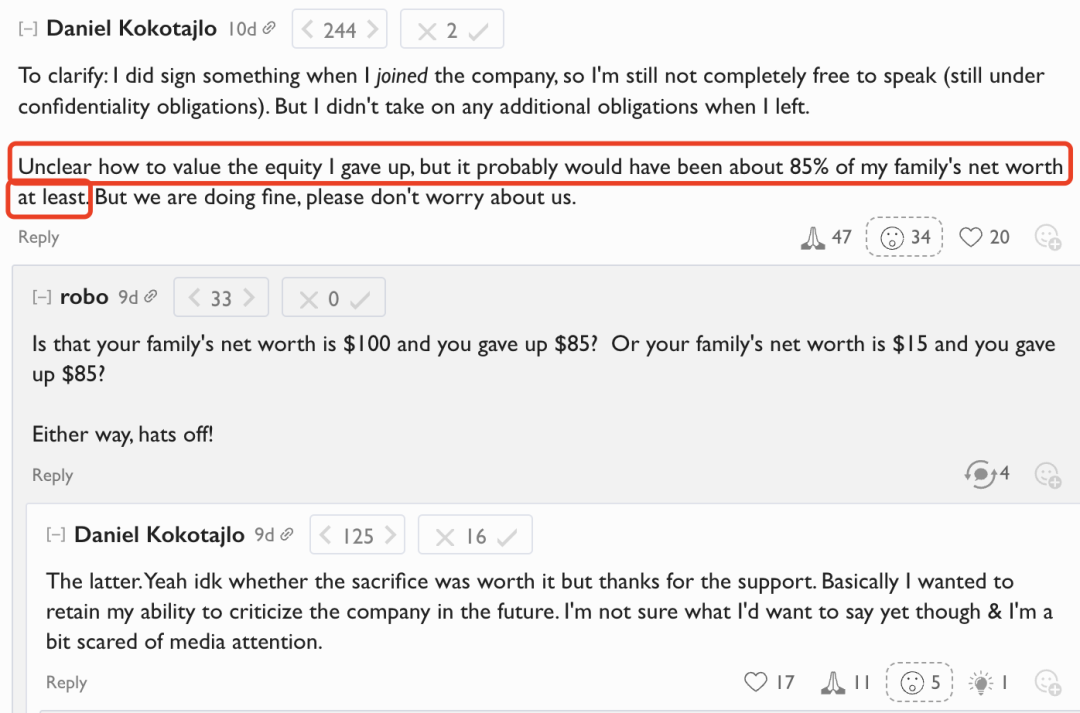

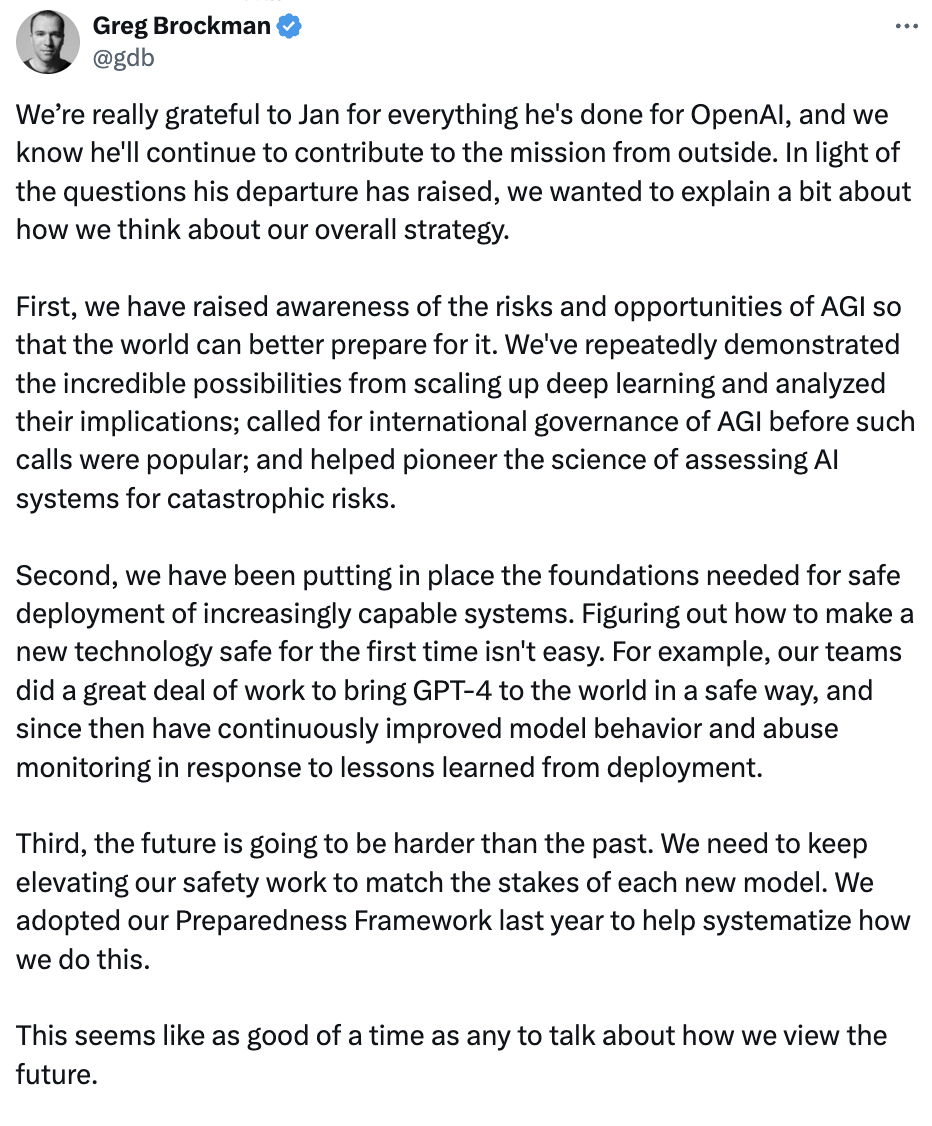

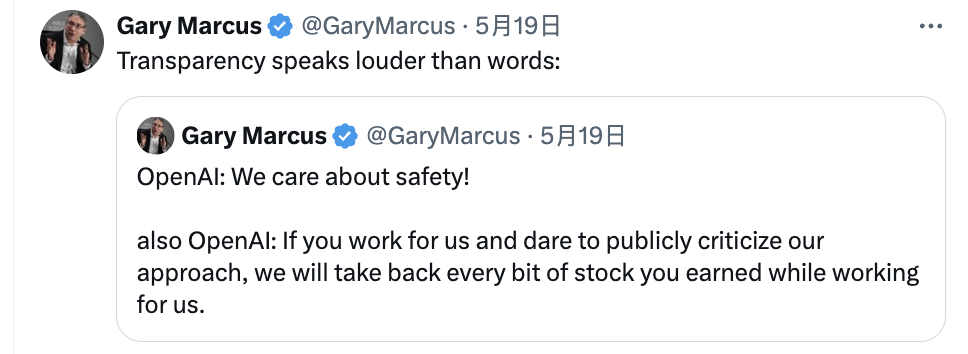

整理 | 屠敏 出品 | CSDN(ID:CSDNnews) 近段时间的 OpenAI 似乎遭遇了“水逆”。 一方面,随着 OpenAI 联合创始人兼首席科学家 Ilya Sutskever 和超级对齐负责人 Jan Leike 相继从 OpenAI 离职之后,有消息称,OpenAI 核心安全团队“超级对齐”已经解散。 另一方面,一波未平一波又起,这两天,一份在离职后不许诋毁 OpenAI 的“离职封口协议”又将 OpenAI 推上了风口浪尖,更有外媒 Vox 直接指出,「OpenAI 最新发布的 GPT-4o 可以让 ChatGPT 像人类一样说话,但是 OpenAI 的员工却不能」。  OpenAI 超对齐团队分崩离析 事实上,上周 OpenAI 联合创始人兼首席科学家 Ilya Sutskever 的离职,虽让人感到遗憾,但也是意料之中的事情。 要知道去年,Ilya Sutskever 参与了导致「 OpenAI CEO Sam Altman 临时被解雇」的董事会叛乱。 历经 12 天的「宫斗」,在 Sam Altman 回归之际,Ilya Sutskever 公开对自己的行为表示遗憾,并支持 Altman 的回归。此后,他便鲜少出现在公众视野。 从其社交媒体账号更新的频次来看,上一次的转发还是在 2023 年 12 月 15 日,而最新的一次便是直接跳到了今年的 5 月 15 日官宣离职。  Ilya Sutskever 的离开,虽引发了外界对“你究竟看到了什么的”猜疑,但是他给了自己和 OpenAI 一份体面,只是官方地说,“我相信 OpenAI 将在 Sam Altman、Greg Brockman、Mira Murati 现在再加上 Jakub Pachocki 出色的研究领导下,打造既安全又有益的 AGI……” 对此,Sam Altman 也非常罕见地发布了一篇正式且深情的长文透露了自己的不舍,“没有他,OpenAl 就不会有今天。虽然他有一些对个人有意义的事情要去做,但我永远感激他在这里所做的一切,并致力于完成我们共同开创的使命。我很高兴能在这么长的时间里接近这样一个真正非凡的天才,一个如此专注于为人类创造最好未来的人。” 然而,与 Ilya Sutskever 的离职形成鲜明对比的是,OpenAI 超级对齐负责人 Jan Leike 的离开。起初,正如此前我们报道的,Jan Leike 的辞职信息很简单,只有短短的两个单词,“I resigned”(我辞职了)。  没有原因、没有未来去向、更没有 OpenAI 高层如 Sam Altman 的祝福。 一切不知是主动还是被动的情况下,外界报道也充满了猜测,也或是被问的多了,Jan Leike 在刚刚过去的周末里,忍不住地连发了 13 条推文,分享了自己离开的想法,更是怒斥 OpenAI 在追求华而不实的产品,质疑 OpenAI 不再关心安全。  以下是他在 X 平台上分享的完整内容: 昨天是我在 OpenAI 担任对齐团队主管、超级对齐负责人和高管的最后一天。 过去 3 年,这真是一段疯狂的旅程。我的团队推出了有史以来第一个使用 RLHF 训练的大模型 InstructGPT,发布了首个可扩展的 LLM 监督,开创了自动可解释性和从弱到强的泛化。更多激动人心的成果即将推出。 我爱我的团队。我非常感谢能与超级对齐团队内部和外部的许多优秀人共事。OpenAI 拥有众多非常聪明、善良、高效的人才。 从这份工作离开,是我做过的最困难的事情之一,因为我们迫切需要弄清楚如何引导和控制比我们聪明得多的人工智能系统。 我最初加入 OpenAI 是因为我认为 OpenAI 是世界上进行此类研究的最佳场所。然而,我与 OpenAI 领导层在公司的核心优先事项上存在分歧已有一段时间,直到我们最终达到了临界点。 我相信我们应该把更多的精力花在为下一代模型做准备上,包括安全、监控、准备、安全、对抗稳健性、(超)一致性、机密性、社会影响和相关主题。 这些问题很难解决,我担心我们还没有走上解决的轨道。 过去几个月,我的团队一直在逆风前行。有时,我们为计算而苦苦挣扎,完成这项至关重要的研究变得越来越困难。 制造比人类更聪明的机器本质上是一项危险的事业。OpenAI 代表全人类肩负着巨大的责任。 但在过去几年中,安全文化和流程已不再受到重视,而光鲜的产品备受青睐。 我们早就应该认真考虑 AGI 的影响了。我们必须优先考虑并尽可能做好准备。只有这样,我们才能确保 AGI 造福全人类。 OpenAI 必须成为一家安全第一的 AGI 公司。 我想对所有 OpenAI 员工说: 学会感受 AGI。 采取与你正在构建的事物相适应的庄重态度。 我相信你可以“实现”所需的文化变革。 我指望你了。 全世界都指望着你。 OpenAI-heart 对此,看热闹不嫌事大的马斯克评论称,这意味着安全并不是 OpenAI 的首要任务。  随着这些内容的公开,次日 OpenAI CEO Sam Altman 才姗姗来迟地现身转发并回应称,“我非常感激 Jan Leike 对 OpenAI 的对齐研究和安全文化做出了贡献,看到他离开,我感到非常难过。他说得对,我们还有很多事情要做;我们致力于这样做。在接下来的几天里,我会有一个更长的帖子。”  据外媒《连线》最新报道,OpenAI 超级对齐团队两大负责人离开之后,这个团队已经解散,余下成员要么辞职,要么将被纳入 OpenAI 的其他研究工作中。 如此迅速的动作,毫无疑问,OpenAI 内部的一线技术人员和管理人员已经分为两个阵营,而对安全等问题着重看重的一方正在相继出走。 针对这一点,也有人好奇,观点的不一致,最终导致他们究竟是被迫还是主动离开。看 Jan Leike 的话语,也存在诸多的无奈才寄希望于留在 OpenAI 的其他人。同时,迄今为止,似乎并没有一个曾经在 OpenAI 工作的人公开谈论过自己究竟为何而离职?  “不贬低”协议曝光 据 Vox 报道,事实证明,之所以没有太多公开消息,是因为有一个非常明确的原因,即 OpenAI 内部有一个极其严格的离职协议,要求从 OpenAI 离职的员工必须遵守一项“不贬低”协议以及保密条款,即禁止这些离职的员工在余生中批评他们的前雇主,同时禁止承认保密协议的存在。 如果离职员工拒绝签署这份文件,或者违反了这份文件,他们就会失去在公司工作期间获得的所有既定股权,这可能价值数百万美元。 此前,一位名叫 Daniel Kokotajlo 的前 OpenAI 员工发帖称,他「因为对 OpenAI 在 AGI 项目会负责任的行事而失去信心」而从 OpenAI 辞职,他已公开证实,为了不签署该文件而辞职,他可能丢了一笔巨款。  事实上,在竞争激烈的硅谷,保密协议并不罕见,但将员工已归属的股权置于拒绝或违反保密协议的风险中却是罕见的。对于像 OpenAI 这样的初创公司的员工来说,股权是一种重要的报酬形式,这种薪酬形式可能会让他们的工资相形见绌。 研究热门科技公司薪酬的咨询公司 Levels.fyi 的创始人 Zuhayeer Musa 曾分享过 OpenAI 员工薪酬构建,多数员工的基本工资约为 30 万美元,每年还会获得约 50 万美元的 PPU(利润参与单位)补助,这是一种股权补偿形式。 所谓 PPU,它的核心价值,就是能够分享 OpenAI 所产生的利润。 Zuhayeer Musa 表示,「签约奖金非常罕见、没有目标绩效奖金、薪酬几乎没有谈判余地」。同时,他指出,在 OpenAI,员工的薪酬会根据经验的不同而有所区别,工资或 PPU 补助会上下浮动几千美元,通常以 2.5 万美元为单位递增。不过,大多数职位的薪酬都接近 30 万美元的工资和 50 万美元的补助金。在 PPU 补助金的四年归属期内,OpenAI 的大多数员工预计将获得至少 200 万美元的股权薪酬。 如果违反所谓的“不诋毁”协议,股权遭到回收,正如前 OpenAI 员工 Daniel Kokotajlo 说的,「不清楚如何评估我放弃的股权,但它可能至少占我家庭净资产的 85% 左右」,成本巨大。  OpenAI CEO 紧急回应 毋庸置疑,这则“不诋毁”协议从根本上封住了离职员工的嘴,也让不少人对 OpenAI 的做法感到诧异与失望。 此消息一经曝出,OpenAI CEO Sam Altman 也坐不住了,立即回应道,这份协议是存在,但是并没有实行过。如今已经责令内部整改。 关于最近有关 Openai 如何处理股权的最新内容: 我们从未收回过任何人的既得股权,如果有人不签署离职协议(或不同意非贬损协议),我们也不会这样做。既得股权就是既得股权。 在我们之前的离职文件中,有一条关于潜在股权注销的规定;虽然我们从未收回过任何东西,但我们不应该在任何文件或沟通中提及这一点。这是我的责任,也是我在运营 OpenAI 的过程中为数不多的真正感到尴尬的一次;我不知道会发生这种情况,但我应该知道。 在过去的一个多月里,我们的团队已经在修正标准离职文件。如果任何签署过这些旧协议的前雇员对此感到担心,他们可以联系我,我们也会解决这个问题。对此我深感抱歉。  显然,对于 Sam Altman 的回应,用户们并不买账,更有人直接质疑道,「如果他们说了一些你不喜欢的话,你怎么能“意外地”加入一条可以取消股权的条款呢?一个“错误”给你带来如此巨大的利益,真是奇怪」,还有网友表示,「如果外媒没有披露出来,这则协议是否还会存在那里?」  OpenAI 不 Open 后,安全存疑? 如果说 OpenAI 决定不开源大模型是不 Open 的行为存在争议,那么如今“离职封口协议”才是真正的「封闭」,外加安全研究人员的相继离职,加剧了外界对于 OpenAI 在安全、可靠性的担忧。 面对外界担心“不可控、或对人类造成重大伤害”的 AI,OpenAI 总裁 Greg Brockman 联合 Sam Altman 也在最新的一天发长文称,他们意识到 AGI 的风险和潜力,称公司已呼吁制定国际 AGI 标准并帮助“开拓者”检查人工智能系统是否存在灾难性威胁的做法。  我们非常感谢 Jan 为 OpenAI 所做的一切,我们知道他将继续从外部为这项使命做出贡献。鉴于他的离职引发了诸多问题,我们想解释一下我们对整体战略的看法。 首先,我们提高了人们对 AGI 风险和机遇的认识,以便世界能够更好地为此做好准备。我们多次展示了扩展深度学习规模的可能性并分析了其影响;在此类呼吁之前,我们就呼吁了对 AGI 进行国际治理;并帮助开创了评估人工智能系统灾难风险的科学。 其次,我们一直在为安全部署能力越来越强的系统奠定必要的基础。弄清楚如何让一项新技术从一开始就变得安全并不容易。例如,我们的团队做了大量工作,以安全的方式将 GPT-4 带给世界,此后,我们根据部署过程中吸取的教训,不断改进模型行为和滥用监控。 第三,未来将比过去更加艰难。我们需要不断提升安全工作,以适应每种新模式的风险。去年,我们采用了“Preparedness Framework”,以帮助将我们的工作系统化。 现在似乎是谈论我们如何看待未来的好时机。 随着模型功能越来越强大,我们预计它们将开始与世界更加紧密地融合。用户将越来越多地与由许多多模式模型和工具组成的系统进行交互,这些系统可以代表他们采取行动,而不是仅通过文本输入和输出与单个模型对话。 我们认为,这样的系统将为人们带来极大的益处和帮助,而且可以安全地交付这些系统,但这需要大量的基础工作。这包括仔细考虑他们在训练时所连接的内容、解决可扩展监督等难题以及其他新型安全工作。在我们朝着这个方向发展的过程中,我们还不确定何时会达到发布的安全标准,如果这会推迟发布时间表也没关系。 我们知道我们无法想象所有可能的未来情景。因此,我们需要非常紧密的反馈循环、严格的测试、每一步的仔细考虑、世界一流的安全性以及安全性和能力的和谐。我们将继续针对不同的时间范围进行安全研究。我们还将继续与政府和许多利益相关者就安全问题展开合作。 目前还没有行之有效的策略指导如何走向 AGI。我们认为经验理解可以帮助指引前进的方向。我们相信,我们既能实现巨大的优势,又能努力降低严重的风险;我们非常认真地对待我们在这里的角色,并仔细权衡对我们行动的反馈。 — Sam 和 Greg 随即,美国 AI 著名学者 Gary Marcus 一句话似乎瓦解了所有的回应,其表示——「透明度胜于雄辩」。  其实,在没有足够清晰的透明度、统一的技术安全措施、积极的反馈处理机制,以及明确的法律和伦理规范之前,大家对 AI 的安全必然会持非常谨慎的态度。这不仅对 OpenAI,而且对所有致力于 AI 发展的企业来说,都必将是一个巨大的挑战。 来源: https://www.vox.com/future-perfect/2024/5/17/24158478/openai-departures-sam-altman-employees-chatgpt-release https://www.businessinsider.com/openai-unique-compensation-package-among-tech-companies-ppu-2023-6 https://x.com/gdb/status/1791869138132218351 推荐阅读: ▶自曝每天花 50% 的时间编码,面试谷歌却遭拒?HR 透露:低于 70% 的不考虑! ▶传微软中国 AI 团队“打包赴美”,涉及数百人?官方回应:是“国际轮岗”,可以不去 ▶盗窃2500万美元,这对MIT毕业的兄弟只用了12秒:被指控3项罪名,每项最高20年监禁 上一篇:短视频剪辑、Java软件开发、Web前端开发27日陆续开课,中级电子商务师学费优惠 下一篇:淘宝客们的微信“大逃杀” |

/1

/1