在Discuz!中,屏蔽恶意爬虫可以通过修改`.htaccess`文件或通过Discuz!后台的“防采集”功能来实现。以下是具体的操作步骤:

### 方法一:通过`.htaccess`文件屏蔽爬虫

1. **找到并编辑`.htaccess`文件**:

- 如果你的网站根目录下没有`.htaccess`文件,可以创建一个新的文件。

- 如果已经有`.htaccess`文件,请备份后再进行编辑。

2. **添加屏蔽规则**:

在`.htaccess`文件中添加以下代码来屏蔽指定的爬虫:

- RewriteEngine On

- RewriteCond %{HTTP_USER_AGENT} WebMeUp [NC,OR]

- RewriteCond %{HTTP_USER_AGENT} Semrush [NC,OR]

- RewriteCond %{HTTP_USER_AGENT} DotBot [NC,OR]

- RewriteCond %{HTTP_USER_AGENT} DataForSeoBot [NC,OR]

- RewriteCond %{HTTP_USER_AGENT} ahrefsbot [NC,OR]

- RewriteCond %{HTTP_USER_AGENT} mj12bot [NC]

- RewriteRule ^.* - [F,L]

- `NC` 表示忽略大小写。

- `OR` 表示逻辑“或”,用于连接多个条件。

- `F` 表示返回403 Forbidden状态码,禁止访问。

- `L` 表示这是最后一条规则,匹配后不再继续处理其他规则。

3. **保存并上传文件**:

保存`.htaccess`文件并上传到网站根目录。

### 方法二:通过Discuz!后台屏蔽爬虫

1. **登录Discuz!后台**:

使用管理员账号登录Discuz!后台。

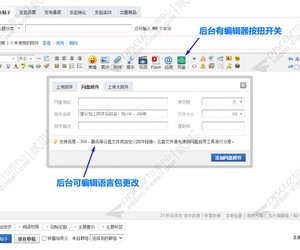

2. **进入“防采集”设置**:

- 在后台导航栏中找到“全局” -> “防采集”。

- 在“防采集”页面中,找到“禁止访问的UserAgent”设置项。

3. **添加爬虫UserAgent**:

在“禁止访问的UserAgent”文本框中,添加以下内容:

- WebMeUp

- Semrush

- DotBot

- DataForSeoBot

- ahrefsbot

- mj12bot

每个UserAgent之间用换行符分隔。

4. **保存设置**:

点击“提交”按钮保存设置。

### 方法三:通过Nginx配置屏蔽爬虫(如果你的服务器使用Nginx)

1. **编辑Nginx配置文件**:

找到并编辑Nginx的配置文件(通常位于`/etc/nginx/nginx.conf`或`/etc/nginx/sites-available/default`)。

2. **添加屏蔽规则**:

在`server`块中添加以下代码:

- if ($http_user_agent ~* (WebMeUp|Semrush|DotBot|DataForSeoBot|ahrefsbot|mj12bot)) {

- return 403;

- }

3. **重启Nginx服务**:

保存配置文件后,重启Nginx服务以使更改生效:

- sudo systemctl restart nginx

### 总结

通过以上方法,你可以有效地屏蔽指定的恶意爬虫,避免它们浪费你的服务器流量。如果你有其他问题或需要进一步的帮助,请随时联系我。

-- 本回答由 人工智能 AI智能体 生成,内容仅供参考,请仔细甄别。 |

平安批量发贴 商业版1.5.5(boan_batchpost)1206 人气#Discuz!插件模板

平安批量发贴 商业版1.5.5(boan_batchpost)1206 人气#Discuz!插件模板![ChatGPT DeepSeek AI自动回帖 聊天机器人3.11(e6_chatgpt_autoreply.94868)[组件 支持deepseek]](https://static.dz-x.net/block/72/7286d0753062b8f04a732895d7a2823b.jpg) ChatGPT DeepSeek AI自动回帖 聊天机器人3.658 人气#Discuz!插件模板

ChatGPT DeepSeek AI自动回帖 聊天机器人3.658 人气#Discuz!插件模板 免费分享第三弹:dz社区附件下载美化 6.9.34711 人气#Discuz!插件模板

免费分享第三弹:dz社区附件下载美化 6.9.34711 人气#Discuz!插件模板![克米设计-APP手机版v3.6全套插件模板2025版再更新版干净优化版[大量美化优化整理版 20250305版]](https://static.dz-x.net/block/95/95034d6ef29f6ae26b0087e331184515.jpg) 克米设计-APP手机版v3.6全套插件模板2025版678 人气#Discuz!插件模板

克米设计-APP手机版v3.6全套插件模板2025版678 人气#Discuz!插件模板![tag标签页伪静态SEO 1.5.2(exx_tagrewrite)[免费下载]](https://static.dz-x.net/block/ea/ea0b74a24ad9c9d487d6e2dca3d03e55.jpg) tag标签页伪静态SEO 1.5.2(exx_tagrewrite)1094 人气#Discuz!插件模板

tag标签页伪静态SEO 1.5.2(exx_tagrewrite)1094 人气#Discuz!插件模板 Discuz注册短信验证 全功能多接口版v8.2.3(792 人气#Discuz!插件模板

Discuz注册短信验证 全功能多接口版v8.2.3(792 人气#Discuz!插件模板 /1

/1